2017/3/17 20:45: 尤度の簡単な説明と、ベイズ統計の応用例についての説明を1つ追加

2017/8/16: 信頼区間, ベイズ統計の定義について補足説明を加筆

2020/8/10 追記: B. Efron and T. Hasite (2016) "Computer Age Statistical Inference: Algorithms, Evidence, and Data Science" はベイズ統計学とそれ以前のパラダイムの立場の違いを明確にした上で(頻度主義統計学の定義をちょっと狭め過ぎな気もするが, 学説史ではないのでそこはまあ...)両者を説明し, 統計学の教科書としてもよくできているのである程度知識のある人はそちらを読んだほうが良い. 『大規模計算時代の統計推論: 原理と発展』というタイトルで邦訳が出ている (ただし私は買ってない)

概要

- ベイズ統計と従来型の古典統計学 (頻度主義統計学) の特徴をそれぞれ挙げた上で, それらの違い, そしてメリットデメリットについて説明してみる.

- 専門的な話題に立ち入らないように, かつそれなりに本質的なことにも踏み込みたいという欲張りな動機で, しょうしょう小難しいがなんとか専門外の人間でも分かるようなレベルにならないかと考えて説明を試みた.

- 自分自身も理論研究の専門家ではないので粗探しすればボロボロ出てくるとは思う.

- 文章量は5ページ分相当.

統計学全般にあまり詳しくない人に「ベイズ統計とはなんなのか」と説明を求められる場面があった. 口頭で説明するよりネット上の適当な記事を見繕って紹介しようかと思ったが, 「主観的な信念を盛り込める」「ベイズ統計と古典統計学は激しく対立している」など, どうも説明が表層的にすぎるもの, あるいはミスリーディングなものが多く, ベイズ統計の特徴と利点・欠点を満足する範囲でカバーしているものが見つからなかった. 個人的には渡辺澄夫先生の書いた各種記事が気に入っているのだが, 統計力学と強く関連付けて書いている点と, 数式をふんだんに使う記事が多い点のため, 専門外の人間や 数学の苦手な人間は読むのに苦労しそうであるという問題点がある. また, https://healthpolicyhealthecon.com/2015/12/18/bayesian-1/ という良い記事も存在するが, 話題が仮説検定に偏っているきらいがある. ベイズ統計と古典統計学とは互いに理念が異なり, 両者の世界観にはそれなりに大きな差があるから, その違いを知っておくのは重要である. しかし抽象的で形式的な論理だけを述べるのはベイズ統計について知りたいと思う多くの人間が求めることではないとも思う. 理念を語ると同時に実用上どのような違いが発生するのかまで説明しなければ, ベイズ統計についての説明として片手落ちになる.

というわけでベイズ統計の説明を自分で書くことにした. 自分自身も専門家と言えるレベルではないし, これ以降は様々な分野について素人解釈で言及することになる *1. そのため以下の文はベイズ統計に関する万人の合意ではなく, あくまでベイズ統計を特徴づけるための一説であるということを念頭に置いて読んでいただきたい.

古典統計学とは

ところで, 先に古典統計学の定義について確認しておく. ここでは「古典統計学」と「頻度主義統計学」を同じ意味で使っている. つまり20世紀初頭に W. ゴセット, F. ゴルトン, K. ピアソンらによって始められ, R. フィッシャー, J. ネイマン, E. ピアソンらによって補強されたもので, 仮説検定や回帰分析など数学的な理論に基づく統計学のことを指す*2. 実はそれ以前にも「統計学」と呼ばれるものは存在した. 詳しいことは省くが, 国勢調査のような大規模なサーベイとその集計を意味し, 世間一般の用法としての「統計学」でいえばこちらのほうが近いかもしれない*3. しかしながら今回は, より古い統計学ではなく, 20世紀初頭に成立した頻度主義統計学を古典統計学と呼ぶ.

決定論と確率論

ベイズ統計も古典統計学も確率論に立脚している. しかしベイズ統計の本質について説明するにはまずは確率論と決定論の違いについて, それから主観確率と客観確率の違いも一旦知っておく必要があると思う. 決定論では, あらゆる現象には不確定要素はなく, すべては必然という立場を取る. 古くはキリスト教神学において, 「全知全能で完璧に世界を計画できる神によって造られた人間に自由意志はあるのか」という論争があった*4. 自然科学においては, この宇宙の現象のメカニズムを説明する模型 (モデル) は, 例えばニュートンの万有引力の法則のように方程式で答えがただひとつに求められる, という解釈になる.

一方で確率論は, 現象にはどこかに偶然に左右される要素があるという立場にある. この偶然を表すのが確率であり, 現象を説明するモデルには確率の要素が含まれる. 古典統計学とベイズ統計学はいずれも「確率がどれくらいの大きさか」を求めることに本質がある. では両者はなぜ異なるのか, なぜ対立していると言われているのか. それは確率の解釈の仕方の違いから発生する.

主観確率と客観確率

話は再び決定論に戻る. ニュートン力学では現象のモデルを方程式で表し, これを解くことで答えを特定できる. 微分方程式をともなう問題なら初期値が必要になるが, やはり答えを1つに特定できる. このように, 当初の物理学は決定論的な見方が主流だった. ラプラスが主張するように, 自然現象は「現在の位置と状態, そして現象の法則さえ分かれば未来も完璧に予測できる」と考えられていた*5. 逆に言えば未来を予測するのに必要な情報が足りないときに, 人間は何らかの信念に基づいて予測するしかない, いわばギャンブルをするような状況である. 確率とはそのような人間の主観的な信念を数値化したものだというのが当時の主観確率の考え方である*6. 一方で客観確率とは, 読んで字のごとく客観的に定義できる確率である*7. 19世紀末から20世紀前半に発生した統計力学 (統計物理学) や古典統計学は客観確率に基づいている.

主観確率と客観確率の違いを考える例として, 新しく六面サイコロを振って5の目の出る確率を考えよう. おそらく多くの人は 1/6 と答えるはずだ. だが, これはどのようにして求めたのか. とうぜんながらサイコロはまだ振られていないので, 答えはわからない. しかし, 6つの目が出る可能性は「同様ニ確カラシイ」から 「1/6」 と答えた. これは主観確率の考え方である.

古典統計学とベイズ統計

無限の試行 (Unlimited Trail Works)

ふたたび前節のサイコロの話に戻る. 客観確率に基づいている古典統計学 (頻度主義統計学) の立場では, サイコロの5の目が出る確率をどう答えるのが正しいのか. 頻度主義とは文字通り頻度を重視する. つまり実際に何度もサイコロを振って, 5の目が出た回数を数えてわかった「頻度」を確率とする. 実際に振るのはルール違反ではないか, という声もあるかもしれないが, 出る目そのものを当てるのではなく, 確率を当てる問題だということに注意していただきたい. 目に穴が彫られているタイプのサイコロは, 重心がズレるため, 全ての目が厳密には 1/6 にならず, 5の目が一番出やすいと言われている*8. このように古典統計学の考えに基づいた実験を行えば, 主観確率に基づいて1/6 と答えるよりも正確な確率が分かりそうである.

古典統計学が頻度を確率とみなす根拠は「大数の法則」という法則にある. この法則は, 同じ条件で無限回繰り返した場合, 頻度は真の確率と一致する, ということを示している. 実際には無限にサイコロを振り続けるということは不可能なので, 適当な回数だけで打ち切る. つまり, 古典統計学では有限回の試行に留めることで, 真の確率の近似値を求めているということになる. 試行回数が多ければ多いほどよりよく近似できるため, 古典統計学では推定の精度を保証するものとしてサンプルサイズの大きさが重要になってくる. ベイズ統計でも大数の法則が利用されているが, サンプルサイズに関する条件はいくらか柔軟である.

なにが「主観的」か

このように古典統計学は頻度主義に基づく厳密さが強みである. ではベイズ統計はこれとはどう違うのだろうか.

ベイズ統計は頻度主義には基づかないため, 客観確率を前提としていない. そのため古典統計学のように常にサンプルサイズの大きさを意識する必要もない. ベイズ統計を用いて推測された確率は事後確率, あるいは事後分布と呼ばれる. 事後確率は、人間が「主観的に」設定した事前分布 (事前確率) と実際のデータによって得られる尤度*9の加重平均によって決まる. これは「ベイズの定理」から導かれたベイズ統計の基本となる公式である*10*11. サイコロの例を引き続き使用するなら, 事前確率は "1/2" となり, 尤度は古典統計学と同様になんらかの観察結果をもとに計算することになる. 一方で古典統計学では事前分布を用いず, 尤度だけを見て, 尤度が最も大きくなるようモデルを決定する. これを最尤法という. 最尤法に対して, 事後確率 (=事前分布+尤度) を最大化するベイズ統計の方法は, 最大事後確率 (MAP)法と呼ばれる*12.

急に尤度の話が出てきたため, 予備知識のない人にはピンとこないかもしれないので, 尤度原理をサイコロの例で説明しておく. 今回は5の目の出る確率がわからないので, これを とする. 5以外が出る確率は

となる*13. あとは実験の結果から5の目の出た数

と 5以外の目の出た数

を利用して一連の実験の結果が起こる確率を

と表せる. これが尤度である.

だけが未知数なので, 尤度が最も大きくなるように

を決める. ベイズ統計の MAP 法であれば, この尤度に事前分布を加味して決めることになる.

このためベイズ統計では, 事前分布の設定を変えれば結果も大きく変わってしまうことがあるというのは事実である. このことから, しばしば巷では「ベイズ統計は分析を行う人間の主観が入り込むいい加減な方法である」という言説がまかり通っている. しかし, そもそも尤度はベイズ統計でも古典統計学でも用いられる概念であり, 尤度はどのようなモデルを設定するかによって変わる. つまり渡辺の 事前分布について でも指摘されているように, なんらかのモデルを設定した時点で人間の直観が紛れ込んでいるではないか. よってベイズ統計でも古典統計学でも使う人間の主観が入り込む点は同じである. さらに補足すると, ベイズ統計の事前分布は「自由に設定していい」ので, 観察されたデータを近似したものを事前分布としてを設定することも許される (これは経験ベイズ法と呼ばれる*14 ). 全てをデータによって決定しているのだから, 古典統計学は客観的でベイズ統計 (経験ベイズ法) は主観的であるというのは矛盾しているのではないか.

ベイズ統計にも古典統計学にも, 推定結果が適切かどうかを判断する方法があるため, まっとうな分析であれば, 都合よく「主観の入り込んだいいかげんな推定」をすることはできないはずである. しかしながら, あらゆる問題を解くのに有効な, 万能の事前分布というものは存在しないため, 事前分布の選択は慎重にしなければならないという実用上の課題はやはり存在する.

2019/7/30 追記: 最近 赤池 (1980) のエッセイを読んだが, 統計モデルを仮定する時点で主観が存在するという指摘がすでになされていた. やはりこういった論争は大昔に終わったことだということか.

より変則的なモデリング

「事前分布が主観的でいい加減である」という難癖を却下したところで, ではベイズ統計の強みとは何なのか, ということを説明していく.

実は, 事前分布の存在こそがベイズ統計の強みの源泉であり, 一方で頻度主義の厳密さこそが古典統計学の弱点にもなっているのである*15.

ある状況では, 古典統計学で使われる最尤法ではうまく推測できないか, そもそも原理上計算できないということがありうる. このような状況では, むしろ事前分布を用いるベイズ統計のほうがうまくいくのである.

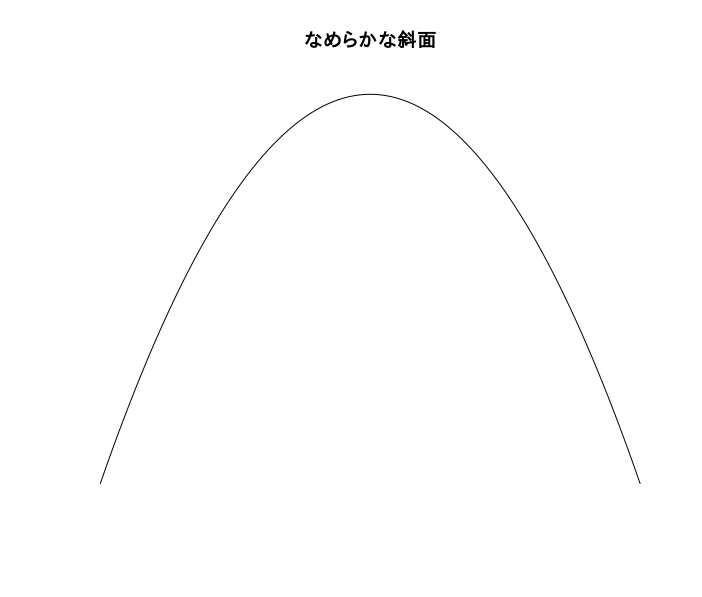

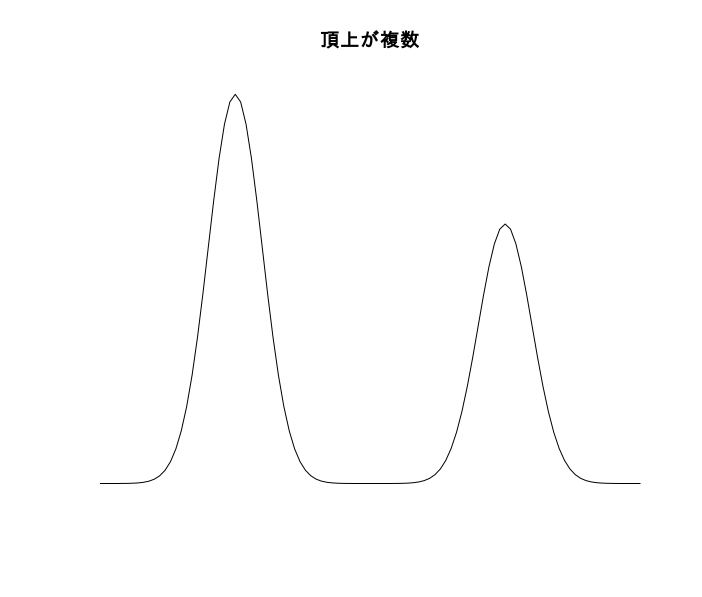

例えば, モデルを表現する式が複雑になると, 最尤法ではうまく推定できない. この感覚的な説明は難しいので, とりあえず次のような比喩のイメージで納得してもらう: 最尤法の計算は山登りに似ていて, 尤度が最も大きくなるところを探すため, 尤度の山の最も高いところを目指して登る. 古典統計学で対処できるモデルでは, 尤度はゆるやかな斜面の山であるので, 山の頂上に登るのは容易である. また, 古典統計学で頻繁に用いられる正規分布は, 山の頂点に当たる場所が, 平均値と中央値と一致しているので, 平均値さえ分かれば分布の傾向を直感的に理解しやすい. しかしモデルが複雑になると, 山の傾斜が左右対称でなく, ゆがんだもの, 山の斜面が険しすぎるもの, 頂上が台地なのでどこが頂上なのかはっきりしないもの, あるいは頂上が複数あるような山がでてくる. このような場合は, 従来の方法でうまく計算できないし, 山の頂点が平均値や中央値に一致するとは限らない. このようなとき, ベイズ統計では事前分布の山を加えることで, 山を登りやすくすることができ*16, また事後分布から乱数生成することで分布の擬似的なヒストグラムを作成することもできる.

さらに, そもそも原理的に最尤法で計算できない場合については, 樋口 (2014) に具体的な例が書かれている. それを要約して説明しよう.

古典統計学の普及していた今までの時代はサンプルサイズ (N) に対して, データの項目数 (説明変数の種類, 以下, P で表す) が少ないのが普通だった. しかし, 「ビッグデータ」の時代ではさまざまな種類のデータを収集できるようになった結果 N よりも P のほうが多いという状況も珍しくなくなった. N の大きさを重視する古典統計学はこのような状況を想定していなかったため, この状況で使うことができなくなる. 具体的には, 以前 科学史から最小二乗法 (回帰分析) を説明してみる - ill-identified diary で書いたように, N より未知数(=P)のほうが多い状況で最小二乗法を適用しても原理的に計算が不可能となる. これは最尤法でも同じである. 一方でベイズ統計はこの問題に対処できる*17.

また, 古典統計学が頻度にこだわるがゆえにベイズ統計に遅れをとる場面もある. つまり, サンプルサイズ N をどう扱うか, という問題である. 古典統計学では個々のデータを数え上げる必要があるので, 個々のデータは互いに無関係でなければならない. もし互いに相関しているなら, データに偏りがあり, 結果にも偏りが出るからである. サイコロの数のように単純な事象なら, 互いに独立しているかどうかはわかりやすい. しかし, モデルが複雑になると, データの最小単位がどこなのかが曖昧になりやすい. 最小単位が不明瞭ということはサンプルサイズも不明瞭であり, 大数の法則をどう適用すればいいのかという解釈が難しくなる. 例えば, 興味の対象が「宇宙全体」の場合, サンプルサイズは1になってしまうのか? あるいは「他の宇宙」も観察してデータを集めるのか? というふうに*18. ただし, ベイズ統計であっても大数の法則を利用する場面はある. 大数の法則が不要なのではなく, なくても大丈夫な場面がある, ということである.

このように, ベイズ統計はより複雑な, 特殊な状況にも対応できるのが強みである. さらに, 最近の研究ではそもそも両者は互いに矛盾する理論ではない, という主張がなされている. 渡辺 (2012) などで説明されているように, 数式上ではベイズ統計と古典統計学は対立するものではなく, 実はベイズ統計は古典統計学を包含する理論であることが説明されている*19. ベイズ統計のうち, 事前分布を設けない特殊なケースが古典統計学であるというのである. しかしながら, これまでに説明したとおり, 確率に対する解釈が異なったという歴史的経緯のために具体的な個別の問題についてはアプローチが異なる場合も多い.

ベイズ統計特有の応用例として, ベイズ更新がある. 事後確率は事前確率と尤度によって得られることは先にも言った通りだが, ここでさらに新たなデータを得られたとしよう. このデータを反映すればより推測の精度が向上しそうである. そこで, 既にある事後確率を事前確率として扱い, 新たなデータを元にして得られた尤度と合わせて新たに事後確率を計算する, ということができる. これがベイズ更新である. 例えば以前 [R] [教材]アニメーションで学ぶカルマンフィルタ - ill-identified diary に書いた カルマンフィルタは, もともとは統計学とは関係なく, センサーなどから得られる情報をもとに機械の状態を把握し, リアルタイムで機械の動きを修正していくという工学の方法論で, 代表例としては人工衛星の軌道制御に応用される. 逐一もたらされる情報をつど更新して反映するというやり方はベイズ更新と非常に相性が良い. そのため時系列分析ではカルマンフィルタとベイズ統計の組み合わせはよく利用される. 一方で, 古典統計学では厳密で計画的な実験を前提としていたため, 後から追加で情報が入ってくるような状況はあまり想定されてこなかった.

そのほか, 古典統計学における信頼区間の定義がわかりにくいのは頻度に立脚した理論に由来する. これは短所というほどではないが, 人に説明するのが面倒だという点では古典統計学の欠点かもしれない. 古典統計学の信頼区間とベイズ統計の信用区間は実質的に同じものを指している (そして名称が似ているために紛らわしい) が, 仮定が異なるために定義に違いが発生する. 信頼区間と信用区間の説明については

id.fnshr.info

の説明がわかりやすい.

2017/8/16 加筆: 古典統計学における, 信頼区間のよくある誤解を簡潔に図示したものを見つけた.

95%信頼区間、誤解していませんか?気になる方は、次回10月19日18時30より京大病院にて行われますセミナーに是非ご参加ください!申し込みフォームはこちらhttps://t.co/NnX78M207E (図は講義資料より抜粋) pic.twitter.com/exeYJhRJqw

— 京都大学臨床統計家育成コース (@KyotoCBC) 2017年8月4日

まとめ

以上の話から, 古典統計学とベイズ統計学の特徴を箇条書きで要約すると以下のようになる.

- 古典統計学は頻度に基づいて確率を定義する. ベイズ統計は主観確率に基づいて確率を定義する.

- ただし数学的には両者は矛盾するものではない.

- ベイズ統計は事前分布の設定に難しさがある.

- ベイズ統計は古典統計学より柔軟にモデルの推定ができる. 具体的には,

- モデルの未知数 (パラメータ) が非常に多い場合

- モデルが複雑な形状をしている場合

- 情報が逐一小出しにされるような場合

参考文献

- Hacking, Ian. 1990. The Taming of Chance. Cambridge University Press. (石原英夫・重田園江訳,『偶然を飼いならす – 統計学と第二次科学革命』,木鐸社,1999 年)

- 作者:イアン・ハッキング

- 発売日: 1999/06/01

- メディア: 単行本

- ———. 2006. The Emergence of Probability. 2nd ed. Cambridge University Press. (広田すみれ・森本良太訳,『確率の出現』 ,慶應義塾大学出版会,2013 年)

- Salsburg, David. 2001. The Lady Tasting Tea: How Statistics Revolutionized Science in the Twentieth Century. Henry Holt; Company. (竹内惠行・熊谷悦生訳,『統計学を拓いた異才たち – 経験則から科学へ進展した一世紀 –』,日本経済新聞出版社,2010 年)

- 作者:デイヴィッド・サルツブルグ

- 発売日: 2010/04/01

- メディア: 文庫

- 赤池, 弘次. 1980 "統計的推論のパラダイムの変遷について." 統計数理研究所彙報 27 (1). 統計数理研究所学術研究リポジトリ

- 樋口, 知之. 2014. “統計数理の誕生とその広がり.” 横幹 8 (1). 特定非営利活動法人 横断型基幹科学技術研究団体連合: 14—21. doi:/10.11487/trafst.8.1_14.

- 渡辺, 澄夫. 2012. ベイズ統計の理論と方法. コロナ社.

- 作者:渡辺 澄夫

- 発売日: 2012/03/01

- メディア: 単行本

*1:あまりにも致命的な誤りがあれば教えていただきたい. 特に物理学関係は完全に素人である.

*2:詳しくはSalsburg (2001) などを

*3:こちらの統計学について知りたい場合は, Hacking (1990) を読むと良い. ただしそれなりに抽象的で難解である.

*4:自由意志については現在も哲学上の論争が続いている

*6:17~19世紀に確率がどのように解釈されていたか詳しく知りたい場合は Hacking (2006) などを参考に. ただしこれもたいぶ難解で、基本的な哲学の知識を要する.

*7:主観確率と客観確率の違いについてもいろいろ論争があるが, あまり詳しくないしこの記事の本題とはズレるのでここでは言及しない

*9:尤度とは, モデルの尤(もっと)もらしさを表す指標である.

*10:ベイズの定理だけなら説明している文献がいくつもあるので適当に探すと良い.

*11:教科書に載っているベイズの定理の公式をそのまま使うなら, 事後確率は確率の積で表現することになる. しかしここでは加重平均 (和) と書いている. これにはなぜかというと, 確率の対数で考えているからである. 計算の簡単さのため, 古典統計学でもベイズ統計でも確率の対数をとって考えることが多い. 対数は積を和に変えてくれるため, 確率の積を計算することの多い統計学の問題を解きやすくすることができる.

*12:最尤法やMAP法はパラメータを1点に特定するため,点推定と呼ばれる. 一方で渡辺 (2011) を始めとする多くの教科書では, ベイズ統計を, ある点を推定するのではなく, 予測値の分布を求める統計学であると定義している. 実際, 予測値を求めたい場合とパラメータを求めたい場合とでは目的が異なるから, これらは厳密には区別されるべきである. しかしここでは, 事前分布を用いるかどうかの簡単な比較を挙げることで, 古典統計学とベイズ統計の違いを説明したいため, MAP法も広義のベイズ統計としている.

*14:ただし, 経験ベイズ法という用語は, この他にも 「第2種の最尤推定」とか「エビデンス近似」とも呼ばれるものを指すこともある. どちらかというとこの用法のほうが正式なものであるようだ.

*15:両者の違いがこれしかないのだから当たり前ではあるのだが……

*16:ただし, 頂上が複数あるような「多峰分布」タイプのものは通常の方法では計算が難しい.

*17:ベイズ統計以外にも, スパースモデリングと呼ばれる分野の方法を使うことで解決できる場合もある. もちろんベイズ統計とスパースモデリングの合わせ技ということも考えられる.

*18:尤度さえ決めれば最尤法が使えるかもしれないが, 統計学でよく使われる理論的な正当性の理由付けは, しばしば大数の法則や中心極限定理といった, 「サンプルサイズが大きいと~~」というものに由来している.

*19:ただしこの本は数式が多数出てくる上に統計力学の知識も多少必要なため, 本記事を読む人にとってはまだ難しすぎると思われる.